L’IA Act – Législation sur l’Intelligence Artificielle

L’IA Act est une proposition de règlement de la commission européenne déposée le 4 avril 2021 dans le but de réguler les systèmes d’intelligence artificielle. Elle va être acceptée au plus tard pendant l’année 2023 et va essayer de mettre en place une harmonie de règles au sein de l’Union Européenne sur la question des traitements des Intelligences Artificielles.

Avec l’avènement de ChatGPT, les scandales des voitures TESLA et autres, les projecteurs sont de nouveaux braqués sur les systèmes d’Intelligence Artificielle.

Ce sujet est, malgré les histoires récentes, un point de discussion depuis bien longtemps et ce depuis la création du concept par John McCarthy en 1960.

Malgré cela, les législations possibles sur ce sujet spécifique de l’Intelligence Artificielle restent plutôt récentes et en particulier, un certain règlement européen va concerner ces Intelligences Artificielles, l’IA Act.

L’IA Act est une proposition de règlement de la commission européenne déposée le 4 avril 2021 dans le but de réguler les systèmes d’Intelligence Artificielle.

Elle va être acceptée au plus tard pendant l’année 2023 et va essayer de mettre en place une harmonie de règles au sein de l’Union Européenne sur la question des traitements des Intelligences Artificielles.

Ce texte IA Act en particulier cherche à fournir une harmonisation des termes, comme celui de système d’Intelligences Artificielles, qui est défini comme un logiciel développé au moyen d’une ou plusieurs techniques et approches et qui peut, pour un ensemble donné d’objectifs définis par l’homme, générer des résultats tels que des contenus, des prédictions, des recommandations ou des décisions influençant les environnements avec lesquels il interagit.

Dans son article 2 le règlement établit son champ d’application dans tous les pays de l’Union européenne et vise les fournisseurs de systèmes d’Intelligence Artificielle dans l’Union européenne, les utilisateurs de ceux-ci, et enfin les fournisseurs de systèmes d’intelligence artificielle dont les seuls résultats des services sont utilisés dans l’Union. De ce fait, le texte va concerner tout système désirant fonctionner dans l’Union Européenne et affectera le développement de l’Intelligence Artificielle de façon mondiale.

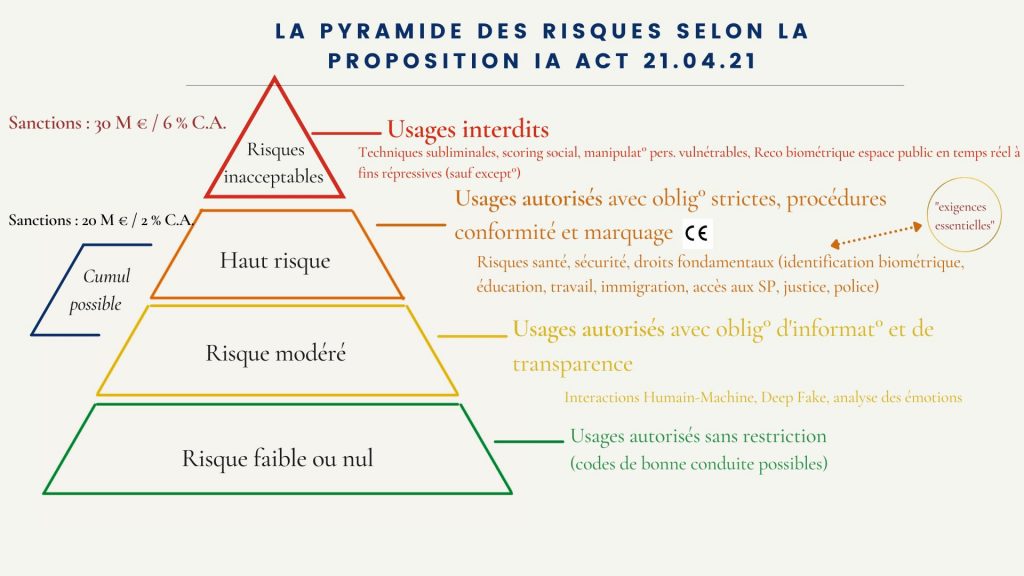

Ce règlement établit différentes catégories de systèmes d’intelligences artificielles afin de mieux les contrôler, à l’exception du développement de l’intelligence artificielle pour les forces militaires qui est exclu du champ d’application du texte.

Les Intelligences Artificielles Interdites liées à l’IA Act

Dans le but de réguler les systèmes d’Intelligence Artificielle, la proposition du texte de loi IA Act décide, qu’en premier lieu, il faut établir une liste des systèmes d’IA interdites, celle-ci se trouve à l’article 5 de la proposition et détermine ceux qui sont interdit :

- Les systèmes d’IA utilisant des techniques subliminales en dessous du seuil de conscience pour altérer le comportement de telle façon qui peut causer un préjudice physique ou psychologique.

- Les systèmes d’IA qui exploitent les vulnérabilités d’un groupe de personnes pour l’âge ou le handicap.

- Les systèmes d’IA générant une note sociale sur la fiabilité d’une personne physique en fonction du comportement social ou des caractéristiques s’ils causent :

- Soit un traitement préjudiciable ou défavorable de personnes physiques ou de groupes entiers dans un contexte social dissocié du contexte de collection des données.

- Soit un traitement préjudiciable ou défavorable de personnes physiques ou de groupes entiers qui sont injustifiés ou disproportionnés par rapport à leurs comportements sociaux.

- Les systèmes d’IA utilisant des systèmes d’identification biométriques à distance en temps réel dans des espaces publics, sauf si :

- Ils servent à la recherche ciblée de victimes de criminalité comme notamment les enfants disparus.

- Ils aident à la prévention d’une menace spécifique, substantielle et imminente pour la vie ou la sécurité des personnes physiques ou encore la prévention d’une attaque terroriste.

- Ils permettent la détection, localisation, identification ou les poursuites à l’encontre de l’auteur ou du suspect d’une infraction pénale qui serait puni d’une durée maximale d’au moins 3 ans.

Il faut noter qu’il est pris en compte la nature de la situation comme la gravité et les conséquences de l’utilisation de ce système sur les droits et libertés. Cela signifie qu’il y a un respect du principe de proportionnalité, c’est-à-dire l’adaptation de la réaction par rapport au risque de préjudice, d’influence négative ou d’atteinte aux droits fondamentaux.

Il y a besoin d’une autorisation de la part de l’autorité nationale en charge avant de pouvoir utiliser ces outils. L’autorité nationale en cause a donc un droit d’appréciation sur l’interdiction des systèmes d’IA dans son pays, nous avons pu voir un exemple en Italie où ChatGPT a été interdite d’utilisation dans toute la nation ou encore les limitations de son utilisation dans les gouvernements de différents pays.

L’appréciation par les autorités nationales permet aux pays membres de l’Union Européenne de tout de même pouvoir juger et être libre de bloquer ces systèmes d’Intelligence Artificielle.

La catégorie des systèmes d’Intelligences Artificielles à Haut Risques

L’IA Act a créé une catégorie de systèmes d’Intelligence Artificielle, la catégorie de système d’Intelligence Artificielle à haut risque. Celle-ci est basée sur 2 conditions cumulatives :

- Un système d’IA qui est destiné à être utilisé comme composant de sécurité d’un produit couvert par les actes législatifs d’harmonisation de l’Union.

- Un système d’IA fait partie de la sécurité d’un produit ou est lui-même soumis à une évaluation de la conformité par un tiers au vu de la mise sur le marché ou de la mise en service du produit conformément aux actes législatifs d’harmonisation de l’Union Européenne.

Autrement dit, les systèmes d’IA visés par les normes de l’Union Européenne pourront être considérés systèmes d’Intelligence Artificielle à haut risque à condition qu’ils soient visé par une protection, une réglementation, de la part d’un acte législatif d’harmonisation de l’Union Européenne, qui se trouvent dans la liste de l’annexe 2 de la proposition qui détermine ces actes législatifs d’harmonisation. Cette limitation de la qualification cherche à ne pas étendre la portée de ce texte afin de pouvoir limiter et contrôler les domaines atteints par celui-ci au fur et à mesure du travail d’harmonisation de l’Union Européenne.

De ce fait, il a été établi dans l’annexe 3 du texte une liste des systèmes d’IA à haut risques qui, selon l’article 7 de la proposition, peut être mis à jour tant que 2 conditions sont remplies :

- Les systèmes d’IA sont utilisés dans les domaines de la liste de l’annexe 3

- Les systèmes d’IA présentent un risque de préjudice pour la santé ou la sécurité, ou un risque d’incidence négative sur les droits fondamentaux.

La liste de l’annexe 3 de la proposition contient à ce jour :

- Les systèmes d’IA sur l’identification biométrique et la catégorisation des personnes physiques avec, en particulier, l’identification biométrique à distance « en temps réel » et à « posteriori » des personnes physiques.

- Les systèmes d’IA pour la gestion et l’exploitation des infrastructures critiques comme le trafic routier, la fourniture d’eau, de gaz, de chauffage et d’électricité

- Les systèmes sur l’éducation et la formation professionnelle comme l’affectation des personnes physiques à des établissements ou des formations professionnelles.

- Les systèmes pour l’évaluation des étudiants d’établissement d’enseignement et de formation professionnelle ainsi que pour l’évaluation des participants à une épreuve pour intégrer ces établissements d’enseignement.

- Les systèmes sur l’emploi et la gestion de la main-d’œuvre et l’accès à l’emploi indépendant comme le recrutement ou la sélection de personnes physiques dans le cadre d’offres et particulièrement le filtrage des candidatures ou encore l’IA utilisée pour des décisions de promotion et de licenciement.

- Les systèmes traitant de l’accès et droits aux services privés essentiels, aux services publics et aux prestations sociales, comme l’analyse de la fiabilité, la solvabilité d’une personne pour leur fournir l’accès à ces services ainsi que de pouvoir leur révoquer, réduire ou récupérer ces prestations et services.

- Les systèmes d’IA destinés à être utilisés par des autorités répressives telles que l’analyse de la fiabilité des preuves au cours d’une enquête ou de poursuites pénales.

- Les systèmes d’IA gérant la migration, l’asile et les contrôles de frontière comme l’analyse des risques de l’immigration, l’analyse de l’état émotionnel d’une personne physique, ou encore l’évaluation des demandes d’asile.

- Les systèmes d’IA traitant de l’administration de la justice et des processus démocratiques comme l’interprétation des faits et de la loi et son application à un ensemble concret de faits.

La qualification de système d’Intelligence Artificielle à haut risque engendre certaines obligations spécifiques à cette catégorie comme l’établissement d’un système de gestion des risques ou encore la mise en place de mesures supplémentaires ou une augmentation de la transparence et de l’information de l’utilisateur.

Les exigences applicables aux systèmes d’IA à Haut Risques liées à l’IA Act

Les systèmes d’Intelligence Artificielle à haut risques ne sont pas les seuls visés par le règlement, il faut aussi prendre en compte les fournisseurs et utilisateurs qui ont des obligations pour s’assurer que les systèmes d’IA ne soient pas générateurs de risque.

Mais, premièrement, il faut traiter des exigences applicables à ces systèmes d’Intelligence Artificielle à haut risque. Pour cela, il faut établir un système de gestion des risques.

Un système de gestion des risques est établi, mis en œuvre, documenté et tenu à jour en ce qui concerne les systèmes d’IA à haut risque selon l’article 9 de la proposition. Cela consiste en un processus qui se déroule sur l’ensemble du cycle de vie d’un système d’IA à haut risque et qui comprend des éléments tels que :

- L’identification et l’analyse des risques connus et prévisibles associées à chaque système d’IA à haut risque.

- L’estimation et l’analyse des risques susceptibles d’apparaître lors de l’utilisation conforme du système par rapport à sa destination.

- L’évaluation des autres risques susceptibles d’apparaître.

- L’adoption de mesures appropriées de gestion des risques, c’est-à-dire que ces mesures doivent :

- Éliminer ou réduire les risques autant que possible.

- Le cas échéant, mettre en œuvre des mesures d’atténuation et de contrôle sur les risques impossibles à éliminer.

- Fournir aux utilisateurs des informations adéquates, en particulier sur les risques encourus ou encore une possible formation à l’utilisation du système d’IA.

Bien sûr, lors de la mise en place de ce système, il est tenu en compte des connaissances techniques, de l’expérience, de l’éducation et de la formation pouvant être attendue de l’utilisateur pour juger de la bonne mise en place de ces systèmes de gestion des risques. Les systèmes d’IA à haut risques sont testés pour mettre en place le système de gestion des risques le plus approprié en fonction de la destination du système d’IA.

En ce sens, il faut ajouter les exigences de transparence et de fourniture d’informations aux utilisateurs afin de veiller au respect des obligations du fournisseur et de l’utilisateur telles qu’une notice d’utilisation dans un format numérique approprié avec des informations sur l’identité du fournisseur, mais aussi les caractéristiques, capacités et limites du système de performance du système d’Intelligence Artificielle à haut risque.

De plus, il faut ajouter des informations sur les modifications du système d’IA, les mesures de contrôle humain présentes et la durée de vie attendue du système d’IA à haut risque.

Les obligations de l’utilisateur et du fournisseur de système d’IA

Un fournisseur de système d’IA à haut risque a un grand nombre d’obligations. Les autorités nationales compétentes ont la charge de tester et vérifier si ces obligations sont respectées, il y a une obligation pour ces fournisseurs de coopérer avec ces autorités.

Parmi les obligations du fournisseur, l’article 16 nous donne une liste de celles-ci :

- Les systèmes d’Intelligence Artificielle doivent être conformes aux exigences de qualité de l’article 17 du règlement.

- Le fournisseur doit mettre en place un système de gestion de la qualité du système d’IA à haut risque.

- Il doit aussi établir la documentation technique de ce système.

- De plus, il doit assurer la tenue des journaux générés automatiquement par le système d’Intelligence Artificielle à haut risque s’il en a le contrôle.

- Le système d’IA à haut risque doit être soumis à la procédure d’évaluation de conformité applicable avant sa mise sur le marché ou mise en service.

- Il doit respecter les obligations d’enregistrement.

- Le fournisseur prend les mesures correctives nécessaires si le système d’Intelligence Artificielle à haut risque n’est pas conforme aux exigences demandées.

- Il faut aussi qu’il informe les autorités nationales compétentes des États membres dans lesquels le système est mis en place ainsi que de la non-conformité et des mesures prises pour y remédier.

- Le fournisseur place le marquage CE sur le système d’IA à haut risque afin d’indiquer la conformité du système par rapport au règlement européen.

- Enfin, le fournisseur doit, à la demande d’une autorité nationale compétente, apporter la preuve de la conformité du système d’IA à haut risque par rapport aux exigences du règlement.

Finalement, le règlement IA Act légifère les systèmes d’IA dangereux pour permettre une harmonie dans le contrôle de ceux-ci en établissant des catégories à haut risque et interdit tout en laissant l’appréciation des systèmes aux autorités nationales compétentes. Cela leur permet d’avoir une certaine liberté sur leurs actions face aux dangers des systèmes d’IA qui se développent ainsi que de faciliter des interdictions et des contrôles inter-États sur ces systèmes d’IA.