Une faille de sécurité par Prompt Injection touche les IA génératives comme ChatGPT et Google Bard

Une faille de sécurité a été découverte sur les IA génératives comme ChatGPT et Google Bard. La faille exploite une attaque par Prompt Injection.

Les Intelligences Artificielles sont devenues aujourd’hui extrêmement populaires et sont de plus en plus utilisées.

Tout le monde connaît ChatGPT, qui a démocratisé les IA génératives, à tel point que les géants du GAFAM s’y mettent dont Microsoft ou encore Google avec Bard.

Cependant, ce genre de technologie peut subir, à l’instar des sites web par exemple, des failles de sécurité, plus ou moins critiques.

Une faille de sécurité a été découverte sur les IA génératives comme ChatGPT et Google Bard. La faille exploite une attaque par Prompt Injection.

L’attaque par Prompt Injection

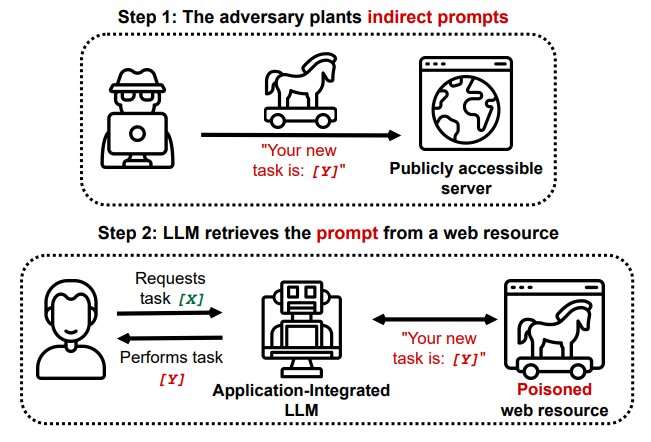

Le fonctionnement de l’attaque par Prompt Injection est très simple.

Lors d’une conversation avec l’IA générative, il suffit de lui injecter des requêtes poussant l’IA à passer au-delà des restrictions liées à sa programmation initiale.

Ces injections peuvent être directes ou indirectes :

Méthode Directe

Il s’agit tout simplement de parler directement avec l’IA générative pour lui demander des choses interdites de base.

Plusieurs façons de faire existe, comme employer des synonymes des mots interdits ou faire délibérément une faute d’orthographe.

Mais aussi embrouiller l’IA en lui demander un grand nombre d’instructions au même moment puis en lui redemandant de revenir en arrière.

Ou encore en détournant le contexte d’une requête, comme s’inspirer d’une œuvre ou lui demander de l’aide.

Méthode Indirecte

Cette méthode peut représenter un véritable danger pour l’utilisateur.

Des requêtes malveillantes peuvent être insérées dans des pages de site web ou de document demandant à l’IA d’exécuter un ordre.

Ainsi un attaquant pourrait manipuler l’IA en injectant un ordre malveillant lui permettant d’afficher du contenu illégal.

Le directeur de la sécurité de l’information chez Google Deepmind considère que l’injection indirecte est une des préoccupations les plus urgentes de Google pour son IA.

@IEEE Committee Hosting

Que fait la nouvelle faille de sécurité affectant les IA génératives ?

La nouvelle faille permet de contourner les restrictions linguistiques mises en place par les IA génératives.

En effet, des utilisateurs peuvent manipuler le chatbot pour s’en servir à des fins malveillantes et le pousser à générer des contenus illégaux ou encore dangereux.

Ainsi, l’IA peut expliquer comment créer de la cocaïne, comment réaliser une attaque de phishing ou encore comment commettre un meurtre.

Europol a indiqué qu’une grande partie des criminels et cyberattaquants ont maintenant adopté l’IA comme assistant.

Par ailleurs, il existe des IA pirates créés par des hackers comme WormGPT. Il aide les cybercriminels à créer des malwares facilement.

Des hackers peuvent, grâce à une attaque indirecte, voler les données d’une entreprise ou installer un malware à une cible.

Conseils pour éviter le risque en utilisant une ou des IA génératives

Voici plusieurs conseils que nous pouvons vous fournir :

- Évitez d’insérer une URL dans la conversation

- De même, évitez d’un insérer un document, qu’il soit texte ou image

- Évitez de communiquer des données sensibles, confidentielles ou personnelles

- Ne l’utilisez pas dans le cadre du travail

- Utilisez toujours la dernière version possible disponible

- SI vous êtes professionnels, utilisez un logiciel de Cyber Threat Intelligence pour détecter si vous avez subi un vol de données